Texto universitario

_____________________________

Módulo 0. Entropía, información e incertidumbre

0.1. Introducción la incertidumbre

La entropía se introdujo originalmente para explicar la intensidad del calor, la presión y la densidad, concepto que se desarrollo gradualmente con el tiempo. Sobre la base del concepto de entropía, se desarrolló la Segunda Ley de la Termodinámica, que establece que es probable que la entropía de un sistema aislado aumente hasta que alcance su estado de equilibrio. Más recientemente, la implicación de la entropía se ha extendido más allá del campo de la termodinámica aplicándose en el abordaje de múltiples áreas de naturaleza probabilística. El concepto de entropía es aplicable y útil para caracterizar el comportamiento de los procesos estocásticos ya que representa la incertidumbre, la ambigüedad y el desorden de los procesos sin restringirse a las formas de las distribuciones de probabilidad teóricas. Para medir y cuantificar la entropía, se debe determinar la probabilidad existente de cada evento en el proceso estocástico. Se han estudiado y presentado diferentes medidas de entropía, incluida la entropía de Shannon, la entropía de Renyi, la entropía de Tsallis, la entropía de muestra, la entropía de permutación, la entropía aproximada y la entropía de transferencia. Intentamos examinar las formulaciones generales de la cuantificación de la incertidumbre, basada en la entropía, así como sus diversas implicaciones. Los resultados de los estudios existentes muestran que las medidas de entropía son predictores poderosos para procesos estocásticos con incertidumbres.

La segunda ley de la termodinámica es fundamental para comprender la energía y la materia en la relación que las vincula, tenga presente que la materia es energía densamente estructurada. La estructura de la materia es un orden de organización de la energía. Y esta ley prevé una tendencia del universo a decaer en sus estructuras conforme viajamos por el tiempo hacia el futuro. Dado que esta ley incluye el concepto de entropía, información y energía, es necesario discutir lo que inició Sadi Carnot en 1824 en su estudio sobre las olas de calor[1]. Los objetos materiales sólidos, líquidos o gaseosos se forman de cantidades enormes de moléculas entre las que se dan interacciones de movimiento; computar el cálculo de trayectorias de todas ellas no es posible. Pero esta nube de entropía (desorden) a menudo exhibe regularidades estadísticas que tienen manifestaciones a nivel macro y esto es lo que permite calcular los eventos de un intenso vibrar de las moléculas.

Nuestra biología intenta oponerse a esta manifestación de la segunda ley, por un lado tiende a evolucionar dentro de un espacio tiempo que la presiona al decaimiento de sus estructuras de organización de la energía en su materia. Más adelante regresaremos a la entropía en los seres vivos, por ahora consideraremos a la vida como una tendencia opuesta a la entropía, una que tiende a crear orden, autoorganización y evolución.

En el estudio de la entropía de las moléculas lo que importa es el volumen, su temperatura y su presión. Maxwell y Boltzman estudiaron estas cualidades que dependen de las configuraciones cambiantes de grandes conjuntos de moléculas; lograron predicciones estadísticas asombrosas, desde luego en términos de probabilidades exactas[2]. El volumen es resultado de las estructuras de organización de las moléculas, las configuraciones de moléculas más pequeñas y densas tienen una entropía baja, caso contrario, configuraciones más grandes de moléculas y distribuidas uniformemente tienen entropía mayor.

La entropía en estas moléculas esta influenciada por la temperatura, que es la velocidad media de un conjunto de moléculas. Si algo se enfría, la velocidad media de las moléculas es baja y si se calienta es alta. A mayor temperatura, mayor entropía. Podemos considerar que las olas de temperatura no son más que un traslado de un lugar a otro de entropía[3].

La presión es el impacto aditivo de cada molécula que ejerce un empuje, cuanto mayor sean las moléculas, más presión ejercen. La presión es dada por el número de moléculas para una temperatura y volumen dado. Si disminuyen las moléculas, se reduce la temperatura y se hace al volumen menor, la entropía es menor. Caso contrario, se incrementa la temperatura o un volumen mayor, será la entropía mayor. Al bajar la entropía considerablemente, se compromete calcular los macroestados a partir de los agentes moleculares. La influencia de fuerzas organizadoras son responsables del orden que observamos. Y en medio de esta discusión, Boltzmann distingue que diferenciar el pasado y el futuro es una cualidad del grado de estructuración o decaimiento del orden.

La segunda ley de la termodinámica está vinculada con el cambio en el tiempo a formas de estructuras ordinarias o crecimiento de entropía. Mientras la primera ley se asocia con la conservación de la energía. La energía se transforma, pero se conserva, con las energías cinéticas, potencial (electromagnética o gravitacional) o térmica (movimiento aleatorio interno de la materia) cuando se realiza su contabilidad, su balance de estado siempre cuadra en ser constante. La segunda ley nos dice que el orden tiende a descender al desorden. Si un sistema físico está en su estado de mayor orden, es posible que decaiga evolucionando a uno de mayor entropía.

Por otro lado, cuanto más fácil es manejar la energía, su calidad es más alta, su cantidad total de energía no cambia, pero su calidad se deteriora. La primera ley refiere que la cantidad de energía se conserva en el tiempo, y la segunda determina que su calidad se deteriora con el paso del tiempo. El futuro del universo, siempre será de menor calidad la energía que la que nos alimentó en el pasado. El pasado tiene menor entropía que el futuro. La segunda ley no prohíbe taxativamente reducir la entropía, esta ley expresa que la naturaleza tiene una mayor tendencia de probabilidad al desorden y es muy baja la probabilidad de reducir la entropía. La naturaleza permite que la entropía disminuya, aunque sea la probabilidad más baja. El futuro es extremadamente distinto al pasado por la alta probabilidad de incremento de la entropía. Las estructuras de organización de la materia son de una entropía muy inferior a la máxima.

La vida y el universo ahora mismo están sorprendentemente debajo de su entropía máxima. Hay en ellos estructuras dentro de estructuras con un orden sorprendente de complejidad. Si el futuro fuese el esperado por la segunda ley de la termodinámica, solo encontraríamos un universo sin vida, en su estructura más ordinaria y dispersa en el espacio (quizás solo electrones, quarks y fotones) de máxima entropía. Una pregunta fascinante es cómo después del Big Bang (un instante de orden máximo) hemos llegado a este estado de entropía menor al máximo, es como si en el mismo instante de esta gran explosión apareciera un Big Bang matemático (el orden necesario que organiza la energía en estructuras que evolucionan hacia la materia altamente organizada). Justo antes del Big Bang se encontraba el orden máximo. Orden refiere a la existencia racional observable de estructuras numéricas, funcionales, geométricas, de probabilidad y sorprendentemente lógica en ellas. Baste con considerar que nuestra vida requiere orden en la organización de las moléculas y que nuestro ecosistema esté lleno de cosas ordenadas (de baja entropía).

El objetivo de la termodinámica es derivar relaciones matemáticas que conectan las diferentes propiedades experimentales de los sistemas macroscópicos en equilibrio, sistemas que contienen un gran número de moléculas, del orden de ![]() o más. Por muy útiles que sean estas interconexiones en la termodinámica no nos dan ninguna información sobre la interpretación o explicación a nivel molecular de las propiedades experimentales observadas. Tal explicación se enmarca más bien dentro de la provincia de la mecánica estadística o termodinámica estadística, conceptos sinónimos. El objetivo es proporcionar la teoría molecular o la interpretación de las propiedades de equilibrio de los sistemas macroscópicos. Cada vez que se plantea la pregunta ¿por qué? En termodinámica, por ejemplo, ¿por qué una constante de equilibrio dada, se observa en la ley Henry, ecuaciones de estado…? si observamos se nos presenta un problema en la mecánica estadística.

o más. Por muy útiles que sean estas interconexiones en la termodinámica no nos dan ninguna información sobre la interpretación o explicación a nivel molecular de las propiedades experimentales observadas. Tal explicación se enmarca más bien dentro de la provincia de la mecánica estadística o termodinámica estadística, conceptos sinónimos. El objetivo es proporcionar la teoría molecular o la interpretación de las propiedades de equilibrio de los sistemas macroscópicos. Cada vez que se plantea la pregunta ¿por qué? En termodinámica, por ejemplo, ¿por qué una constante de equilibrio dada, se observa en la ley Henry, ecuaciones de estado…? si observamos se nos presenta un problema en la mecánica estadística.

Aunque la termodinámica en sí misma no proporciona la imagen molecular de la naturaleza, esto no siempre es una desventaja. Por lo tanto, hay muchos sistemas complicados para los que una teoría molecular aún no es posible; pero independientemente de las complicaciones a nivel molecular, la termodinámica todavía se puede aplicar a estos sistemas estocásticos con confianza y exactitud.

Entropía es un término importante por muchas razones, su función principal en la termodinámica es cuantificar la irreversibilidad de un proceso termodinámico, sobre objetos microscópicos compuestos de muchas partes del mismo tamaño que forman un sistema complejo que tiende al equilibrio de sus variables termodinámicas como presión, volumen, temperatura, número de masa atómica, energía interna y por supuesto entropía. Algunas de estas variables están relacionadas a través de ecuaciones de estado.

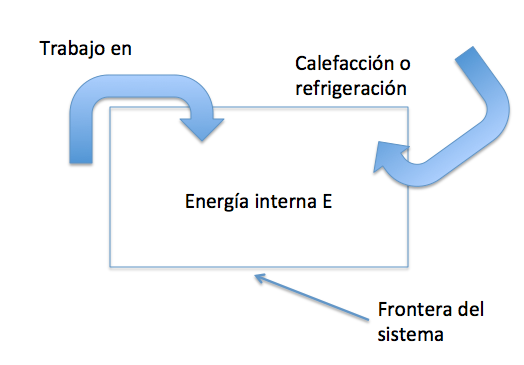

Un sistema termodinámico experimenta un proceso cuando las variables que lo describen cambian desde un conjunto de valores a otro distinto, es decir, cambian de estado termodinámico. Cuando se exhibe una energía igual o isoentrópico, es decir, constante, como ocurre en un sistema completamente aislado, se dice que es adiabático porque no intercambia energía. Las leyes de la termodinámica limitan las maneras en que un sistema puede proceder de un estado a otro. La primera ley termodinámica es la ley de conservación de la energía, aplicada a la energía interna de un sistema termodinámico. La energía interna no incluye la energía de la posición o movimiento del sistema como un todo. Según la primera ley, hay solo dos maneras de cambiar la energía interna de un sistema dado. La primera por calefacción o sistema de enfriamiento, y dos, trabajando en el sistema o arreglos para que el sistema trabaje en su entorno. Matemáticamente esta primera manera le corresponde la ecuación:

![]() Ec. 1.1

Ec. 1.1

Donde ![]() es el incremento de energía interna E de un sistema termodinámico, dado por transiciones de un estado inicial

es el incremento de energía interna E de un sistema termodinámico, dado por transiciones de un estado inicial ![]() a otro final

a otro final ![]() . La cantidad Q es la energía absorbida por el sistema cuando se calienta, y W es el trabajo realizado en el sistema durante la transición. Estas son cantidades asignadas así que cuando Q < 0, el sistema se enfría en vez de calentarse y cuando W > 0, se trabaja sobre el sistema. Cuando estos cambios son infinitesimales la expresión se hace:

. La cantidad Q es la energía absorbida por el sistema cuando se calienta, y W es el trabajo realizado en el sistema durante la transición. Estas son cantidades asignadas así que cuando Q < 0, el sistema se enfría en vez de calentarse y cuando W > 0, se trabaja sobre el sistema. Cuando estos cambios son infinitesimales la expresión se hace:

![]() Ec. 1.2

Ec. 1.2

Aquí hay diferentes notaciones, ![]() versus

versus ![]() , para destacar que mientras que E es una variable que describe el estado de un sistema, Q y W no lo son, dado que indican la cantidad de energía infinitesimal transferida hacia o desde un sistema. Así, ¿un sistema termodinámico contiene energía?, de hecho no, contiene calor o trabajo, como sugiere la Figura 1.1.

, para destacar que mientras que E es una variable que describe el estado de un sistema, Q y W no lo son, dado que indican la cantidad de energía infinitesimal transferida hacia o desde un sistema. Así, ¿un sistema termodinámico contiene energía?, de hecho no, contiene calor o trabajo, como sugiere la Figura 1.1.

Fig. 1.1 La energía interna E de un sistema termodinámico puede cambiarse de dos maneras: 1) por calefacción y refrigeración, y 2) por trabajo.

Todas las interacciones entre partículas fundamentales son reversibles. La interacción más simple es una colisión entre dos partículas fundamentales. Una partícula se aproxima a otra; interactúan mediante fuerzas gravitacionales, electromagnéticas o nucleares; entonces ellas se alejan unas de otras. Podríamos pensar la colisión como dos canicas dentro de un frasco de canicas de igual característica, donde una está inicialmente en reposo y la otra está en (p. ej. movimiento), decimos que las interacciones entre partículas fundamentales son en el tiempo reversibles.

No puede decirse lo mismo de los procesos de un sistema termodinámico compuesto, como es de muchas partes diferentes, son normalmente irreversibles. Sin embargo, hay un sentido especial en el que un proceso termodinámico significativo se puede invertir. Si se hace un pequeño cambio infinitesimal en el sistema o en su ambiente y luego se invierte la dirección del cambio del proceso, uno pensaría que el proceso es termodinámicamente reversible. Sadi Carnot (1796-1832) creó el concepto de reversibilidad termodinámico para expresar y demostrar lo que ahora se llama Teorema de Carnot: el motor térmico más eficiente es aquel que opera reversiblemente[4].

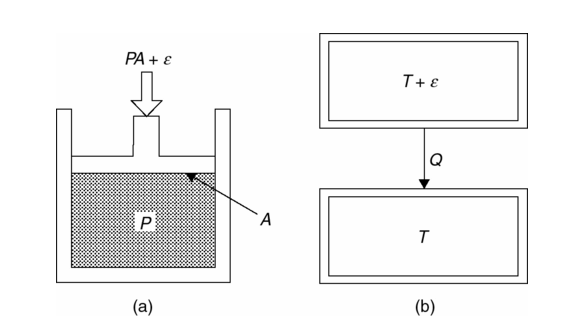

Un proceso termodinámico reversible debe ser cuasiestático, es decir, infinitesimal lento y sin fricción o disipación (fricción interna). Consideremos, por ejemplo, el pistón que comprime el fluido ilustrado en la Figura 1.2a. El pistón cuasiestático y fricción casi despreciable, comprime el fluido cuando la fuerza del pistón se ejerce sobre el fluido, ![]() , es una cantidad indefinidamente pequeña más grande que la fuerza PA a la que el fluido de presión P que se ejerce sobre la cabeza del pistón de área A. Cuando en cambio, la fuerza ejercida por el émbolo sobre el líquido es infinitamente menos que PA, es decir,

, es una cantidad indefinidamente pequeña más grande que la fuerza PA a la que el fluido de presión P que se ejerce sobre la cabeza del pistón de área A. Cuando en cambio, la fuerza ejercida por el émbolo sobre el líquido es infinitamente menos que PA, es decir, ![]() , el fluido se expande cuasiestático. Así, estos son cambios termodinámicamente reversibles porque su dirección puede invertirse para un cambio infinitesimal en el sistema o en su ambiente. De manera similar, el calentamiento o enfriamiento de un sistema por parte de otro sistema, es reversible cuando se mantiene una diferencia de temperatura infinitesimal entre los dos como se muestra en la Figura 1.2b. Claramente, la reversibilidad termodinámica es un ideal que puede ser abordado, pero nunca en la realidad plenamente. Todos los procesos termodinámicos reales son irreversibles.

, el fluido se expande cuasiestático. Así, estos son cambios termodinámicamente reversibles porque su dirección puede invertirse para un cambio infinitesimal en el sistema o en su ambiente. De manera similar, el calentamiento o enfriamiento de un sistema por parte de otro sistema, es reversible cuando se mantiene una diferencia de temperatura infinitesimal entre los dos como se muestra en la Figura 1.2b. Claramente, la reversibilidad termodinámica es un ideal que puede ser abordado, pero nunca en la realidad plenamente. Todos los procesos termodinámicos reales son irreversibles.

Fig. 1.2 (a) Un pistón sin fricción reversible comprime un fluido. (b) Dos sistemas con una temperatura infinitesimal de diferencia de calor al enfriarse en contacto mutuo entre sí se vuelven reversibles.

En síntesis, todos los procesos fundamentales o idealizados son reversibles porque uno puede imaginar invertir su dirección del cambio sin violar las leyes de la física. Por otro lado, todos los procesos termodinámicos no idealizados son irreversibles. Los procesos termodinámicos, en la práctica, proceden siempre en una dirección.

¿Por qué no todos los procesos son reversibles? Se sugiere que las leyes que gobiernan las interacciones de partículas fundamentales no forman una imagen completa de la naturaleza y necesitan ser complementadas con la física adicional equivalente a la segunda ley de la termodinámica.

Hay un número de versiones lógicamente equivalentes de la segunda ley. Rudolph Clausius (1822-1888) fue el primero en 1850, en identificar una versión de la segunda ley de la termodinámica[5]. Para este propósito Clausius elevó las observaciones sobre calefacción y refrigeración para el estado de una ley general: un objeto frío nunca calienta un objeto más caliente. Por ahora basta con entender por temperatura como un valor pico promedio en alguna escala de medición y que una fuente de energía será un reservorio de calor.

Un reservorio de calor mantiene la misma temperatura independientemente de cómo interactúan un refrigerante o una calefacción. Así un reservorio de calor tiene la capacidad infinita de calor como si estuviera indefinidamente creándolo. En el lenguaje del reservorio de calor, Clausius enunció la segunda ley.

En 1851, William Thomson, más tarde conocido como Lord Kelvin formuló una versión distinta de la segunda ley, se refiere a la operación de un motor térmico, es decir, un dispositivo que utiliza una diferencia de temperatura para producir trabajo[6]. Según la segunda ley de Kelvin: un motor de calor cuyo único resultado es causar un reservorio de calor, solo pierde energía Q a través de refrigeración y es imposible que realice la misma cantidad de trabajo![]() .

.

Teniendo en cuenta la primera ley, la versión de Kelvin de la segunda ley es lógicamente equivalente a la de Clausius. Pero la de Kelvin parece la más indicada desde el punto de vista del lenguaje tecnológico.

La segunda ley de la termodinámica puede ser también expresada en términos del lenguaje de procesos irreversibles. Hay que recordar que establecimos que un proceso real es irreversible, es decir, no se puede revertir completamente. Por lo tanto, otra forma de decir esto es que un determinado proceso es prohibido, es decir que el proceso es el resultado de la inversión de un proceso termodinámico irreversible.

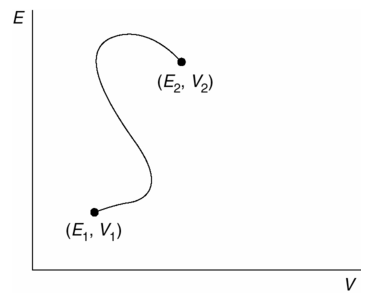

Imagine un sistema termodinámico que puede existir en diversos Estados termodinámicos. Representamos cada uno de estos Estados por un punto en un espacio multidimensional de estados termodinámicos. Las variables que definen el espacio de estado, por supuesto, dependerán de la naturaleza del sistema. Por ejemplo, dos variables son las que determinan el estado de un fluido simple, el estado de un fluido cuyos puntos están definidos por la ubicación de los valores en dos ejes, uno etiquetado como energía E y otro como volumen V. Ahora, elegimos dos puntos cualquiera que representen dos Estados diferentes en nuestro espacio de estado termodinámico y un camino a través del espacio de estado que conecte a estos dos puntos. Cada punto en este camino necesariamente representa un estado termodinámico y la ruta de acceso completa, representa necesariamente un proceso cuasiestático que conecta los dos Estados extremos.

Fig. 1.3 Espacio termodinámico de estados, dos estados, denotados como ![]() y

y ![]() , y un camino conecta a los dos estados.

, y un camino conecta a los dos estados.

Por supuesto que un cambio no cuasiestático, por ejemplo una turbulencia o explosiones de reacción rápida, pueden también transformar un sistema de estado termodinámico en otro. Pero procesos no cuasiestáticos no están compuestos de una secuencia continua de estados termodinámicos y no pueden ser representados por un camino en el espacio de estado termodinámico. Por lo tanto, un camino en el espacio de estado termodinámico representa necesariamente un proceso cuasiestático. Y los procesos cuasiestáticos vienen en dos tipos: procesos reversibles que se producen sin fricción o disipación, y los procesos reversibles que su proceder es con fricción y disipación. Recordar que un proceso totalmente reversible es también uno para el que un sistema y su ambiente puede con ajustes infinitesimales retornar, evolucionar a lo largo de un camino en el espacio de estado en cualquier dirección; y un proceso irreversible es aquel en el que un sistema y su ambiente requieren ajustes finitos para proceder a lo largo de un camino en cualquier dirección. Cada segmento de un trozo en el espacio de estado representa un proceso cuasiestático que, a su vez, representa ser reversible o un proceso irreversible.

Si necesitamos una medida cuantitativa de la irreversibilidad del proceso cuasiestático, Clausius construye una variable de estado para un sistema aislado que monótonamente cambia a lo largo de un camino que representa un proceso irreversible y que sigue siendo el mismo a lo largo de un camino que representaría un proceso reversible. Por lo tanto, dos estados de un sistema aislado, conectados por un camino reversible tienen el mismo valor de esta variable de estado, y dos estados de un sistema aislado conectados por un camino irreversible tienen diferentes valores de la variable de estado. Y es Clausius quien acuña la palabra entropía para referirse a esta variable de estado como un significado paralelo a la palabra energía, esta palabra entropía fue denotada con el símbolo S. La palabra entropía significa literalmente “a su vez” o “entregar” desde su raíz griega Turn. Pero Clausius la interpretó como metáfora de transformación de contenido.

La entropía de un solo Estado, es como la energía absoluta de un solo Estado. Si bien las leyes I y II de la termodinámica no refieren a energía en lo absoluto, si asignan significado a las diferencias de energía y entropía. La tercera ley de la termodinámica, en efecto no permite asignar un significado al concepto de entropía absoluta. Pero antes de adentrarnos en la tercera ley, es necesario estudiar cómo la diferencia entre dos estados de un sistema aislado cuantifica la irreversibilidad de un proceso de conexión de esos dos estados.

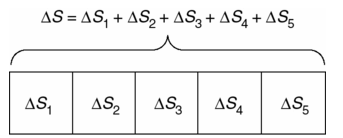

La clave para cuantificar la irreversibilidad de la evolución de un sistema aislado, exige que el incremento de entropía ![]() de un sistema compuesto aditivo se distribuya sobre sus partes. Simbólicamente se expresa así:

de un sistema compuesto aditivo se distribuya sobre sus partes. Simbólicamente se expresa así:

![]() Ec. 1.3

Ec. 1.3

Donde ![]() es la entropía final del sistema j partes,

es la entropía final del sistema j partes,![]() es la entropía inicial del sistema j partes,

es la entropía inicial del sistema j partes, ![]() y

y ![]() es la entropía incremental del sistema j partes. De esta manera, el incremento de un sistema compuesto

es la entropía incremental del sistema j partes. De esta manera, el incremento de un sistema compuesto ![]() es la suma de los incrementos de entropía de sus partes.

es la suma de los incrementos de entropía de sus partes.

Ahora apliquemos estas ideas a un proceso en particular. Establezcamos un reservorio de calor que se calienta con la temperatura T al absorber energía Q. Si, por otra parte, el depósito de calor se enfría, entonces Q<0. Por lo tanto, si el depósito de calor incrementa su entropía puede ser una función solamente de dos cantidades: la temperatura T del reservorio y el calor Q donde el signo de Q indica la energía que es absorbida a través de calefacción o rechazada a través de refrigeración. El calor sustantivo es aquí la energía absorbida o rechazada por calefacción o refrigeración. La ecuación de relaciones de estado.

![]() Ec. 1.4

Ec. 1.4

Tenga en cuenta que no nos hemos impuesto ninguna restricción especial en el proceso del sistema de este calentamiento o enfriamiento. En particular la calefacción o refrigeración se describe en la ecuación anterior la cual puede ser reversible o irreversible.

La propiedad de adición restringe severamente la forma de la función. Por ejemplo, si dividimos un reservorio de calor de temperatura T que absorbe calor Q en dos partes idénticas, cada una conserva la temperatura T y cada una absorbe la mitad del calor Q/2. Puesto que el incremento de entropía del sistema compuesto es la suma de los incrementos de entropía de sus partes

![]()

O equivale

![]()

Si en lugar de incrementos de entropía de calor en dos piezas idénticas, lo dividimos en n:

![]() Ec. 1.5

Ec. 1.5

Allí solo hay una solución no trivial:

![]() Ec. 1.6

Ec. 1.6

Donde g es una función de la temperatura T aún indeterminada. Podemos derivar Ec. 1.6 tomando la derivada parcial de Ec. 1.5 con respecto de n, y resolviendo la ecuación en derivadas parciales resultantes. Por consiguiente la entropía del depósito de calor con cambios de temperatura T es:

![]() Ec. 1.7

Ec. 1.7

Cuando el reservorio absorbe o rechaza energía Q, respectivamente, de refrigeración o calefacción de otro objeto.

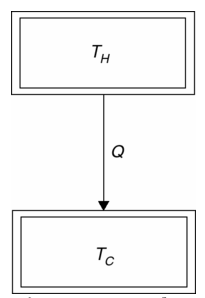

El problema de la generación de entropía de un sistema de dos reservorios. A continuación aplicamos estas ideas a un sistema compuesto por dos reservorios que experimentan el siguiente proceso irreversible: un depósito más caliente directamente transfiere energía Q a un reservorio más frío como lo ilustra la Figura 1.4. Puesto que el depósito absorbe la energía Q y el depósito más caliente rechaza energía Q, sus incrementos de entropía son, respectivamente:

![]()

y

![]() para Q>0

para Q>0

De acuerdo con estas expresiones y la propiedad aditiva, el incremento de entropía de este sistema compuesto de dos reservorios:

![]() Ec. 1.8

Ec. 1.8

Si los depósitos de calor de dos reservorios que forman un sistema aislado compuesto tienen la misma temperatura ![]() , entonces

, entonces ![]() . Y si sus temperaturas

. Y si sus temperaturas ![]() y

y ![]() son diferentes, entonces el calor fluye irreversiblemente desde el depósito más caliente al más frío y es diferente de cero

son diferentes, entonces el calor fluye irreversiblemente desde el depósito más caliente al más frío y es diferente de cero![]() . De esta manera el incremento de entropía

. De esta manera el incremento de entropía ![]() cuantifica la irreversibilidad de un proceso termodinámico de un sistema aislado. En resumen, cuando el proceso es reversible

cuantifica la irreversibilidad de un proceso termodinámico de un sistema aislado. En resumen, cuando el proceso es reversible ![]() y cuando es irreversible

y cuando es irreversible ![]() .

.

Fig. 1.4 Depósitos y transferencia de energía.

Clausius adoptó la convención de que la entropía de un sistema aislado aumenta cuando el sistema evoluciona irreversiblemente en la dirección permitida por la segunda ley de la termodinámica. Así, según lo convenido por Clausius, ![]() en

en ![]() . Este convenio significa que

. Este convenio significa que ![]() y por lo tanto

y por lo tanto ![]() debe ser una función no negativa, decreciente de la temperatura T.

debe ser una función no negativa, decreciente de la temperatura T.

Proceso reversible entre calefacción y refrigeración. Fácilmente podemos superar la restricción de ![]() de calor limitado por Q a una indefinida cantidad pequeña

de calor limitado por Q a una indefinida cantidad pequeña ![]() . La transferencia de una cantidad de calor

. La transferencia de una cantidad de calor ![]() , debe ser reversible, puesto que el sentido de la transferencia puede invertirse por un pequeño cambio en el sistema o su ambiente. En este caso

, debe ser reversible, puesto que el sentido de la transferencia puede invertirse por un pequeño cambio en el sistema o su ambiente. En este caso ![]() reduce la expresión:

reduce la expresión:

![]() Ec. 1.9

Ec. 1.9

La ecuación anterior se aplica a cualquier sistema termodinámico con temperatura T que absorbe ![]() o rechaza una pequeña cantidad indefinida de energía

o rechaza una pequeña cantidad indefinida de energía ![]() mediante calefacción o refrigeración. Después de todo cualquier sistema finito actúa como un reservorio de calor en relación a una cantidad indefinidamente pequeña de calefacción o refrigeración. Una vez más observe la distinción en Ec. 1.9 entre diferencial de un ds variable de estado y el

mediante calefacción o refrigeración. Después de todo cualquier sistema finito actúa como un reservorio de calor en relación a una cantidad indefinidamente pequeña de calefacción o refrigeración. Una vez más observe la distinción en Ec. 1.9 entre diferencial de un ds variable de estado y el ![]() como incremento indefinidamente pequeño.

como incremento indefinidamente pequeño.

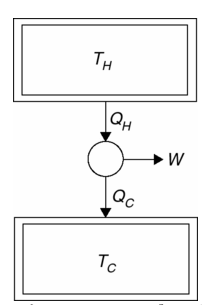

La eficiencia de Carnot y el teorema de Carnot. Una consecuencia de la versión entrópica de la segunda ley, la entropía de un sistema aislado no puede disminuir. El teorema de Carnot: el motor térmico más eficiente es aquel que opera reversiblemente. Para ver esta observación, el motor de calor más simple de Carnot es uno que extrae energía ![]() por enfriamiento de un depósito más caliente, produce trabajo W, y rechaza el desperdicio

por enfriamiento de un depósito más caliente, produce trabajo W, y rechaza el desperdicio ![]() calentando a un reservorio frío como se ilustra en Figura 1.5. Se puede, hacer parte de un sistema aislado de energía, digamos, usando el trabajo W para elevar un peso. La entropía del sistema aislado es:

calentando a un reservorio frío como se ilustra en Figura 1.5. Se puede, hacer parte de un sistema aislado de energía, digamos, usando el trabajo W para elevar un peso. La entropía del sistema aislado es:

![]() Ec. 1.10

Ec. 1.10

donde ![]() y

y ![]() y W son relacionadas, según la primera ley, por:

y W son relacionadas, según la primera ley, por:

![]() Ec. 1.11

Ec. 1.11

Fig. 1.5 El motor de calor más simple posible es el que produce trabajo operando entre un solo reservorio frío y otro caliente.

La eficiencia de este motor es, por definición, como beneficio del motor en el trabajo W que produce, dividido por el calor que consume ![]() , es decir:

, es decir:

![]() Ec. 1.12

Ec. 1.12

Donde, dada la Ec. 1.11 y 1.12 vemos que ![]() . Empleando Ec. 1.11 y 1.12 para eliminar

. Empleando Ec. 1.11 y 1.12 para eliminar ![]() y

y ![]() de la entropía incremental de Ec.10, produce:

de la entropía incremental de Ec.10, produce:

![]() Ec. 1.13

Ec. 1.13

Por lo tanto, cuanto mayor sea la eficiencia ![]() , más pequeño es el incremento de entropía

, más pequeño es el incremento de entropía ![]() . Puesto que no puede disminuir la entropía de un sistema aislado, que es

. Puesto que no puede disminuir la entropía de un sistema aislado, que es ![]() , la mayor eficiencia posible

, la mayor eficiencia posible ![]() tiene lugar cuando

tiene lugar cuando ![]() , es decir, cuando el motor opera reversiblemente. Esta eficiencia máxima del motor de calor entre dos reservorios de calor se presenta como:

, es decir, cuando el motor opera reversiblemente. Esta eficiencia máxima del motor de calor entre dos reservorios de calor se presenta como:

![]() Ec. 1.14

Ec. 1.14

La expresión anterior es conocida como la eficiencia de Carnot y la versión del motor de calor más simple posible, es dada cuando el intercambio de calor entre los dos reservorios es reversible en el llamado motor de Carnot.

La temperatura absoluta o termodinámica. Ni la entropía incremental ![]() , ni la eficiencia de Carnot

, ni la eficiencia de Carnot ![]() se cuantifican plenamente porque para ellas una función no negativa decreciente

se cuantifican plenamente porque para ellas una función no negativa decreciente ![]() aún no está completamente especificada. William Thomson advirtió la falta de especificidad en 1848, veinticuatro años después de que Carnot probó el Teorema en 1824, y dos años antes que Rudolph Clausius había armonizado la primera y segunda ley de la termodinámica en 1850.

aún no está completamente especificada. William Thomson advirtió la falta de especificidad en 1848, veinticuatro años después de que Carnot probó el Teorema en 1824, y dos años antes que Rudolph Clausius había armonizado la primera y segunda ley de la termodinámica en 1850.

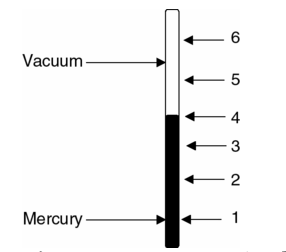

Temperatura. Pero primero ¿qué es la temperatura? Un termómetro mide la temperatura, pero ¿qué es un termómetro? Un termómetro asocia el tamaño de una variable termométrica conveniente, con el volumen, resistencia, color o alguna otra variable termodinámica de un sistema, con un número único denominado según una escala de temperatura, por ejemplo, grados Fahrenheit o Celsius. Consideremos, por ejemplo, el termómetro de vidrio de mercurio ilustrado en la Figura 1.6. La longitud de la columna de mercurio en el tubo de vidrio de calibre pequeño es la variable termodinámica y la forma dispuesta de los números que están en el lado del tubo de vidrio definen la escala de la temperatura.

Fig. 1.6 Termómetro de mercurio con escala de temperatura arbitraria.

William Thomson trató de utilizar el motor de Carnot, es decir, un motor térmico reversible operando entre dos depósitos de calor, como un termómetro y su eficiencia ![]() como variable termométrica. Por supuesto, el motor de Carnot es una idealización que puede ser abordada pero él nunca se dio cuenta. Después de todo, un motor térmico reversible funcionaría infinitesimalmente y sin fricción o disipación, de tal manera que el más mínimo cambio en el sistema o su ambiente fuera a revertir su funcionamiento. No importa que no se pueda construir un perfecto motor térmico reversible y sus reservorios de calor idealizados. Simplemente la mejor aproximación de construcción posible exigirá extrapolar los resultados.

como variable termométrica. Por supuesto, el motor de Carnot es una idealización que puede ser abordada pero él nunca se dio cuenta. Después de todo, un motor térmico reversible funcionaría infinitesimalmente y sin fricción o disipación, de tal manera que el más mínimo cambio en el sistema o su ambiente fuera a revertir su funcionamiento. No importa que no se pueda construir un perfecto motor térmico reversible y sus reservorios de calor idealizados. Simplemente la mejor aproximación de construcción posible exigirá extrapolar los resultados.

La idea es simple, aunque su ejecución es difícil. En primer lugar, asignar una temperatura ![]() a algunas prácticas y estándares universales de estado accesibles, un estándar. Tal estado de agregación es el punto triple del agua, es decir, el estado en que las tres fases del agua están en equilibrio. En segundo lugar, medir la eficiencia de un motor térmico reversible

a algunas prácticas y estándares universales de estado accesibles, un estándar. Tal estado de agregación es el punto triple del agua, es decir, el estado en que las tres fases del agua están en equilibrio. En segundo lugar, medir la eficiencia de un motor térmico reversible ![]() operando entre dos depósitos de calor, uno en equilibrio con el estado estándar y otro en equilibrio con el sistema cuya temperatura

operando entre dos depósitos de calor, uno en equilibrio con el estado estándar y otro en equilibrio con el sistema cuya temperatura ![]() debe ser determinada. Tercero, si

debe ser determinada. Tercero, si ![]()

![]() Ec. 1.15a

Ec. 1.15a

y si ![]()

![]() Ec. 1.15b

Ec. 1.15b

Las temperaturas ![]() asignadas de esta manera se llaman temperaturas absolutas o termodinámicas, mientras que temperaturas T determinadas por otras clases de termómetros se llaman temperaturas empíricas.

asignadas de esta manera se llaman temperaturas absolutas o termodinámicas, mientras que temperaturas T determinadas por otras clases de termómetros se llaman temperaturas empíricas.

Este algoritmo permite asignar la temperatura absoluta o termodinámica a cualquier sistema, en particular a los reservorios fríos y calientes entre ellos los que se operan como un motor térmico reversible (reservorio y depósito son empleados como términos iguales). En cuanto a las temperaturas termodinámicas asignadas según Ec. 1.15, la eficiencia de Carnot de un motor térmico reversible operado entre dos depósitos de calor dados por:

![]() Ec. 1.16

Ec. 1.16

donde ![]() y

y ![]() son absolutas o temperaturas termodinámicas.

son absolutas o temperaturas termodinámicas.

Escalas absolutas de temperatura. La característica esencial de la temperatura absoluta o termodinámica es que la relación entre cualquier par de temperaturas, es decir ![]() ,

, ![]() o

o ![]() es independiente de la escala que se utiliza para denominar las temperaturas individuales. Por ejemplo, en el SI o Sistema Internacional asigna a una temperatura estándar absoluta

es independiente de la escala que se utiliza para denominar las temperaturas individuales. Por ejemplo, en el SI o Sistema Internacional asigna a una temperatura estándar absoluta ![]() = 273.16K para el punto triple del agua. De esta manera hay, 100 grados Kelvin entre el punto normal de congelación del agua, 273.15 K , y el punto normal de ebullición del agua, 373.15 K. La unidad del IS de temperatura absoluta, es el grado Kelvin y su símbolo K, por supuesto, nombrado en honor a Lord Kelvin (William Thomson). Algunas ocasiones los ingenieros utilizan la escala de grados Rankine

= 273.16K para el punto triple del agua. De esta manera hay, 100 grados Kelvin entre el punto normal de congelación del agua, 273.15 K , y el punto normal de ebullición del agua, 373.15 K. La unidad del IS de temperatura absoluta, es el grado Kelvin y su símbolo K, por supuesto, nombrado en honor a Lord Kelvin (William Thomson). Algunas ocasiones los ingenieros utilizan la escala de grados Rankine ![]() , que se simboliza Ra dada en el punto triple del agua. De esta manera el tamaño de grado Rankine es idéntico al tamaño de un grado Fahrenheit.

, que se simboliza Ra dada en el punto triple del agua. De esta manera el tamaño de grado Rankine es idéntico al tamaño de un grado Fahrenheit.

En el sistema Internacional todas las otras clases de temperaturas se definen como funciones lineales de las temperaturas Kelvin. La traducción de un tipo de temperatura a otra es sencilla. Por ejemplo, para convertir 23 grados centígrados a Kelvin simplemente añadimos 273 a los 23 grados, es decir 296 K. Y convertir 68 grados Fahrenheit a Celsius, nosotros substraemos 32 a 68 y multiplicamos el resultado por 5/9 esto da como resultado 20 grados Celsius.

0.2 Construcción de la función de entropía

Observar la termodinámica de un sistema físico, es la vista de una caja negra. Al medir la entrada y la salida de una caja negra, sus características superficiales medidas con manómetros, termómetros… son determinadas. Las leyes de la termodinámica rigen las relaciones entre estas mediciones. La primera ley enuncia que la energía de la caja negra aislada nunca puede cambiar, mientras que la segunda ley establece que la entropía de una caja negra aislada nunca puede disminuir. De cuerdo con estas leyes y estas medidas la caja negra tiene una función de entropía S (E,V,…,) cuya dependencia reside en un pequeño conjunto de viables que encapsula todo lo que se puede conocer del sistema de la caja negra.

Pero no estamos satisfechos con las cajas negras, especialmente cuando funcionan muy bien. Queremos mirar dentro de una caja negra y ver qué hace que funcione. Sin embargo, cuando miramos por primera vez en la caja negra de un sistema termodinámico vemos aún más sistemas termodinámicos. Una casa es un sistema termodinámico, una habitación y cada cajón de la alacena también lo es. Pero los sistemas termodinámicos reales no pueden subdividirse indefinidamente. En algún momento los conceptos y métodos de la termodinámica dejan de aplicarse. Eventualmente, las subdivisiones de un sistema termodinámico dejan de ser pequeños subsistemas y en su lugar se convierten en grupos de átomos y moléculas. El físico austriaco Ludwig Boltzmann (1844-1906) pensó en términos de átomos y moléculas en un momento en que su realidad todavía podía ser cuestionada. La distinción entre átomos y moléculas no siempre fue importante para Boltzmann, pero insistió en su realidad. En particular, Boltzmann relacionó la entropía de un sistema termodinámico con las posibles disposiciones de sus átomos y reinterpretó la segunda ley de la termodinámica en términos de los números de sus posibles arreglos atómicos. Al hacerlo Boltzmann ayudó a crear el enfoque estadístico de la termodinámica, pero, estos logros le costaron mucho esfuerzo y en su época se resistieron fuertemente a sus ideas.

Mientras que el concepto de átomo florecía como una partícula indivisible en el siglo V a.c. con los pensadores griegos Leucippus y Democritus, la primera evidencia empírica de su existencia llegó mucho más tarde, alrededor de 1800, como resultado de la interpretación de Joseph Proust (1854-1926) y la de John Dalton (1766-1844). Pero ni la interpretación de Proust y Dalton, así como las especulaciones de Boltzmann obligaron a creer en los átomos.

Ernst Mach (1838-1916), un influyente colega contemporáneo de habla alemana y colega de Boltzmann, rechazó rotundamente la existencia de átomos. Según Mach y los que adoptaron su filosofía de la ciencia, los átomos añaden poco o nada a nuestra comprensión del mundo. El objetivo de la ciencia es correlacionar directamente las cantidades observables de la forma más precisa y económica posible. En este sentido, la termodinámica es la ciencia perfecta porque logra este objetivo sin demostrar estas entidades “invisibles al ojo humano”. Dado la precariedad de lo conocido (las evidencias o demostraciones) hasta ese momento Boltzmann encontró difícil contrarrestar las críticas de Mach.

La posición de Boltzmann no fue apoyada por sus deficiencias como escritor. Aunque era un científico sobresaliente, los libros y documentos de Boltzmann no son concisos ni claros[7]. Más bien, sondean intuitivamente y en el proceso enmascaran suposiciones importantes. Así Boltzmann incito a la crítica a desestimar sus publicaciones. A la edad de 62 años, el 5 de septiembre de 1906, acosado por la ceguera y los periodos de depresión, Boltzmann se quitó la vida. Boltzmann no era consciente en ese momento de que su larga lucha por introducir átomos en la física había sido reivindicada. Para Albert Einstein (1879-1955) en 1905 había demostrado en un artículo sobre el movimiento Browniano que los movimientos aleatorios de partículas pequeñas pero visibles suspendidas en el agua eran una consecuencia directa de los movimientos aleatorios de átomos y moléculas invisibles aún más pequeñas.

Mientras que el camino de descubrimientos de Boltzmann lo llevó a través de su famoso teorema H, nuestro camino explota las ideas de aquellos que desde la muerte de Boltzmann han reflexionado sobre el significado de su obra. Cuando Boltzmann visualiza el interior de un sistema termodinámico vio no solo átomos y moléculas, sino también sus posibles arreglos. Pero ¿qué es un arreglo o como decimos ahora un microestado? Considere un sistema simple que contiene solo tres partículas. Podrían ser átomos de tres elementos diferentes o podrían ser partículas idénticas que de alguna manera son distinguibles. El sistema se divide en dos partes de volumen igual, los lados izquierdo y derecho, entre los cuales las partículas pueden moverse libremente. Aunque simple, este sistema es lo suficientemente complejo como para ilustrar la distinción entre un sistema, sus macroestados y sus microestados.

Un microestado se identifica mediante una descripción detallada del nivel de partículas del sistema. Debido a que cada una de las tres partículas de este sistema puede realizar diferentes microestados.

Un macroestado consta de un conjunto de microestados que se pueden describir con un conjunto relativamente pequeño de variables. En contextos más realistas un macroestado es un estado termodinámico o de equilibrio y las variables en términos de las que se describe son las variables termodinámicas E, V, M,…, Considere el macroestado del sistema de las tres partículas, y dos lados en los que el volumen del macroestado se distribuye dos partículas del lado derecho y la partícula restante está en el lado izquierdo. Este número de microestados también puede calcularse eligiendo dos partículas con el propósito de colocarlas en la mitad correcta, entre las tres disponibles. Podemos elegir la primera partícula de tres maneras y la segunda de dos maneras entre las partículas restantes para un total de 6 o 3!=3x2x1 maneras. Dado que el orden en el que las dos partículas se colocan en el lado derecho es irrelevante para el propósito de contar microestados, dividimos 6 por el número de formas de ordenar dos partículas, es decir, por 2 o 2!=2x1. De esta manera encontramos el número de microestados en el que dos de tres partículas ocupan la cámara a la derecha para ser 3 o 3!/(2!1!).

Este sencillo ejemplo se puede generalizar de varias maneras. Si el sistema contiene N partículas en lugar de 3, y todavía tiene dos lados diferentes que pueden ser ocupados por cada partícula, el coeficiente binomial ![]() , es decir, “N elegir n”, identifica el número de formas que es posible distribuir N elementos distintos entre los dos lados, uno con n partículas y el otro con N-n partículas.

, es decir, “N elegir n”, identifica el número de formas que es posible distribuir N elementos distintos entre los dos lados, uno con n partículas y el otro con N-n partículas.

Al describir estos microestados y macroestados hemos distinguido cada partícula de todas las demás. Las partículas clásicas siempre se pueden distinguir entre sí. Esto no se debe a que las partículas clásicas necesariamente tienen características distintivas, sino más bien porque sus diferentes trayectorias a través del espacio y el tiempo siguen siendo distintas.

Hubiera sido natural que Maxwell, Boltzmann y otros físicos del siglo XIX, asumieran que el mundo invisible y submicroscópico de átomos y moléculas es simplemente inexistente reduciéndose a la una versión visible y macroscópico. De hecho, Boltzmann argumentó que las partículas, átomos y moléculas definitivamente siempre se distinguen unas de otras. Adoptamos esta suposición de partículas idénticas, cuando llenamos un contenedor con gas helio, podemos, al menos de acuerdo con los principios de la física clásica, seguir sus trayectorias con precisión indefinida.

Según el postulado fundamental de la mecánica estadística, los microestados de un sistema termodinámico asilado son igualmente probables. Dado que el sistema simple de tres partículas y dos lados tienen 8 microestados consistentes con su descripción y cada uno, según el postulado fundamental, es igualmente probable, la probabilidad de que este sistema se disponga de cualquiera de estos 8 microestados sea 1/8. Además, debido a que el macroestado con exactamente dos partículas en su estado derecho se realiza en 3 de 8 microestados igualmente probables, la probabilidad de este macroestado es 3/8.

La probabilidad igual supuesta de los microestados de un sistema aislado es el material del que componemos la probabilidad de un macroestado. Según el postulado fundamental, la probabilidad de un macroestado es proporcional al número de microestados contenidos en un macroestado. Boltzmann llamó al número de microestados que componen un macroestado su permutabilidad. Nosotros usamos la palabra multiplicidad y la denotamos con el símbolo ![]() .

.

El postulado fundamental no se aplica a todos los sistemas aislados, sino solo a aquellos cuyos microestados se definen de tal manera que su misma probabilidad es plausible. Adoptamos este postulado fundamental como una forma de cuantificar nuestro conocimiento parcial del estado de dicho sistema, para evitar sesgar las asignaciones probabilidad cuando no tenemos ninguna razón para preferir un micro estado sobre otro. Aun así, el postulado fundamental no se deriva de principios aún más fundamentales y no puede ser probado directamente. En cambio, se adopta el postulado de microestados equiparables como una hipótesis plausible de la que se obtienen consecuencias que pueden ser probadas.

Llamamos a un sistema al que el postulado fundamental aplica, un sistema termodinámico. En general, los sistemas termodinámicos son sistemas de equilibrio o estado estacionario en el sentido de que se pueden describir en términos de variables termodinámicas que no cambian con el tiempo mientras el entorno del sistema no cambie en el tiempo. Los sistemas termodinámicos siempre se pueden describir con algunas variables y sus macroestados siempre se pueden caracterizar por su multiplicidad. El postulado fundamental implica que un sistema termodinámico asilado se mueve probabilísticamente y sin sesgo entre todos sus posibles microestados. Pero si es así, un sistema también puede moverse entre conjuntos de microestados que corresponden a macroestados inusuales, por ejemplo, el aire corriendo a una esquina de una habitación o a una taza de té caliente convirtiéndose en una aún más caliente en una tarde fría. Nunca observamos evoluciones macroestados tan contra-intuitivas, no porque sean imposibles, sino más bien porque son extremadamente improbables. Las multiplicidades de estos macroestados contra-intuitivos no observados son abrumadoramente pequeños en comparación con las multiplicidades de los macroestados que se observan invariablemente.

Puede ser sorprendente que no se nos dé una versión estadística de la entropía ya hecha, sino que se construya a partir de propiedades deseables y las leyes de la termodinámica. Para comenzar su construcción consideremos los procesos irreversibles en la entropía como en la siguiente figura:

18.55.39.png)

Figura 1.7 Procesos irreversibles de la entropía

En la primera secuencia, las partículas de un gas se limitan a la mitad de un espacio dividido por un barrera, se elimina la barrera y las partículas de gas llenan el espacio disponible. En el segundo, dos cuerpos idénticos con diferentes temperaturas, TH y TC<TH, están separadas por una barrera adiabática, la barrera se elimina y los dos cuerpos se acercan al equilibrio térmico.

En cada una de estas transiciones irreversibles la entropía de un macroestado de un sistema aislado aumenta de un valor inicial Si a un valor final Sf>Si de acuerdo con la segunda ley de la termodinámica. Al mismo tiempo, el número de microestados accesibles para el sistema aislado aumenta de un valor inicial ![]() a un valor final

a un valor final ![]() . Esta correlación entre la evolución de la entropía S de un sistema aislado y la evolución de su multiplicidad

. Esta correlación entre la evolución de la entropía S de un sistema aislado y la evolución de su multiplicidad ![]() sugiere que la entropía estadística de un macroestado es una función monotónica

sugiere que la entropía estadística de un macroestado es una función monotónica ![]() cada vez mayor de la multiplicidad macroestado. Suponiendo que tal función existe es el primer paso en la construcción de una definición de entropía estadística.

cada vez mayor de la multiplicidad macroestado. Suponiendo que tal función existe es el primer paso en la construcción de una definición de entropía estadística.

Boltzmann, en su histórico artículo de 1877, sugirió que la función está adecuadamente expresada por la proporcionalidad ![]() . Más tarde, Max Planck (1858-1947) a partir de una hipótesis razonable, deriva que la relación

. Más tarde, Max Planck (1858-1947) a partir de una hipótesis razonable, deriva que la relación ![]() , k es una constante universal. Aquí seguimos y al mismo tiempo generalizamos la construcción de Planck. Si bien nuestra derivación es larga, emergemos con un resultado solo un poco más complejo que el de Planck, la entropía de un sistema aislado en un macroestado es

, k es una constante universal. Aquí seguimos y al mismo tiempo generalizamos la construcción de Planck. Si bien nuestra derivación es larga, emergemos con un resultado solo un poco más complejo que el de Planck, la entropía de un sistema aislado en un macroestado es ![]() , k es una constante universal y c es una constante que asegura que la entropía es una variable de estado aditiva.

, k es una constante universal y c es una constante que asegura que la entropía es una variable de estado aditiva.

La aditividad es la segunda propiedad que incorporamos a nuestra definición de entropía estadística. En consecuencia, la entropía S de un sistema compuesto por dos partes:

19.55.45.png)

Figura 1.8 Ejemplos de entropía en un sistema compuesto por dos partes

En el que cada parte en sí misma un sistema aislado, denotado como A y B, es aditivo en el sentido de que la entropía del sistema compuesto es la suma de la entropía de sus partes. Así:

![]()

Donde ![]() es la entropía compuesta del sistema. La adopción de la aditividad asegura que la entropía estadística así construida será consistente con el requisito sobre la aditividad de los incrementos de la entropía termodinámica. La notación

es la entropía compuesta del sistema. La adopción de la aditividad asegura que la entropía estadística así construida será consistente con el requisito sobre la aditividad de los incrementos de la entropía termodinámica. La notación ![]() permite asumir, en general, pueden ser muy diferente entre sí como en, por ejemplo, un sistema compuesto por una botella de gas helio en una esquina de un laboratorio y un cristal de sal en otra.

permite asumir, en general, pueden ser muy diferente entre sí como en, por ejemplo, un sistema compuesto por una botella de gas helio en una esquina de un laboratorio y un cristal de sal en otra.

Dado que la entropía estadística es una función de multiplicidad del macroestado ![]() , la aditividad implica que:

, la aditividad implica que:

![]()

Donde ![]() es la multiplicidad de un macroestado de un subsistema A, respectivamente

es la multiplicidad de un macroestado de un subsistema A, respectivamente ![]() es la multiplicidad de un macroestado de un subsistema B, y

es la multiplicidad de un macroestado de un subsistema B, y ![]() es la multiplicidad de un macroestado del sistema compuesto A+B. Cuando dos subsistemas son simplemente copias más pequeñas del sistema compuesto, las funciones

es la multiplicidad de un macroestado del sistema compuesto A+B. Cuando dos subsistemas son simplemente copias más pequeñas del sistema compuesto, las funciones ![]() y

y ![]() y las multiplicidades

y las multiplicidades ![]() y

y ![]() deben estar igualmente estructuradas y la aditividad se reduce a la extensividad.

deben estar igualmente estructuradas y la aditividad se reduce a la extensividad.

Independencia

En tercer lugar, suponemos que los subsistemas asilados A y B, dan cuenta independientemente de sus macroestados. Por lo tanto, la multiplicidad del sistema compuesto es dada por:

![]()

Y la condición ![]() se transforma en:

se transforma en:

![]()

En realidad, el aislamiento mismo de los dos subsistemas implica la independencia de sus macroestados. Este resultado ![]() incorpora las tres condiciones siguientes: la independencia de la entropía en la multiplicidad de macroestado, la aditividad y la independencia de subsistemas aislados.

incorpora las tres condiciones siguientes: la independencia de la entropía en la multiplicidad de macroestado, la aditividad y la independencia de subsistemas aislados.

Exploración de derivadas

Ahora tomamos derivadas de la expresión ![]() con respecto a las multiplicidades macroestado

con respecto a las multiplicidades macroestado ![]() y

y ![]() , una táctica que reduce una condición más fuerte (aditividad de entropías) a una más débil (aditividad de incrementos de entropías). Si queremos restaurar todo el contenido de la aditividad, debemos volver a imponer el resultado de nuestras derivadas. Las dos derivadas parciales son:

, una táctica que reduce una condición más fuerte (aditividad de entropías) a una más débil (aditividad de incrementos de entropías). Si queremos restaurar todo el contenido de la aditividad, debemos volver a imponer el resultado de nuestras derivadas. Las dos derivadas parciales son:

![]()

y

![]()

Donde un primer símbolo ‘ indica una derivada con respecto al argumento indicado. Por ejemplo, ![]() . Igualamos las expresiones anteriores:

. Igualamos las expresiones anteriores:

![]()

Puesto que las variables ![]() y

y ![]() realizan sus valores de forma independiente, esta ecuación implica que:

realizan sus valores de forma independiente, esta ecuación implica que:

![]()

y

![]()

Donde, formalmente, k es una constante de separación. La integración de estados da forma a las expresiones:

![]()

Donde ![]() y

y ![]() son constantes de integración.

son constantes de integración.

El significado de constante

Nos detenemos para considerar la naturaleza de las tres constantes k, ![]() y

y ![]() , generadas por la resolución de las ecuaciones diferenciales acopladas:

, generadas por la resolución de las ecuaciones diferenciales acopladas:

![]()

y

![]()

La palabra constante siempre debe incitarnos a preguntar: ¿Constante con respecto de qué? En este caso, a las variables en cuanto a las cuales las derivadas que se definen, es decir, constantes con respecto a las multiplicidades macroestados ![]() y

y ![]() .

.

La constante k está restringida adicionalmente. Puesto que k está asociada con los subsistemas A y B (en realidad, a cualquier número de subsistemas), k es independiente de los parámetros que identifican cualquier macroestado particular de cualquier sistema o subsistema en particular. En síntesis, k es una constante universal. Max Planck fue el primero en enfatizar la universalidad de k. En su honor H. A. Lorentz (1853-1928), por un tiempo, calificó la constante k de Planck. Sin embargo, frase constante de Planck es meritoria de otros dominios, y nos referimos a k como constante de Boltzmann. Encontramos que ![]() , donde R es engañosamente llamada “constante de los gas” y

, donde R es engañosamente llamada “constante de los gas” y ![]() es el número de Avogadro. En el Sistema internacional SI, el valor de la constante de Boltzmann es dada por:

es el número de Avogadro. En el Sistema internacional SI, el valor de la constante de Boltzmann es dada por:

![]()

Por lo que, las unidades de k constante de Boltzmann son la energía sobre la temperatura termodinámica, es decir, k tiene las unidades de entropía.

La entropía estadística de un sistema asilado. Si combinamos nuestra ecuación:

![]()

Aplica a un sistema compuesto por subsistemas A y B. Aditividad e independencia, o equivalencia, luego requieren que las tres constantes ![]() ,

, ![]() y

y ![]() , estén relacionadas por:

, estén relacionadas por:

![]()

Por lo tanto, cuando aplicamos el resultado general:

![]()

A un sistema compuesto y a cada una de sus dos partes asiladas, siempre debemos estar dispuestos a adoptar ![]() con el fin de restaurar el contenido completo de la aditividad a nuestra definición de entropía estadística.

con el fin de restaurar el contenido completo de la aditividad a nuestra definición de entropía estadística.

Podemos expresar el resultado general ![]() en una forma reveladora escribiendo dos diferentes macroestados del mismo sistema, un estado inicial denotado por i y uno final denotado por f, y restando las dos ecuaciones entre sí. De esta manera encontraremos que:

en una forma reveladora escribiendo dos diferentes macroestados del mismo sistema, un estado inicial denotado por i y uno final denotado por f, y restando las dos ecuaciones entre sí. De esta manera encontraremos que:

![]()

Combinando:

![]()

Este resultado especialmente útil para describir el incremento de entropía de un sistema aislado sometido a un cambio irreversible.

En particular ![]() nos permite reiterar la segunda ley de la termodinámica en el lenguaje de multiplicidad. Debido a que un sistema aislado puede relajarse pero nunca puede imponer una restricción interna, la multiplicidad del macroestado final de un sistema aislado es al menos tan grande como la multiplicidad de su macroestado inicial. Algunos textos caracterizan la transición irreversible de un sistema internamente restringido a uno menos restringido como uno de un macroestado relativamente ordenado a uno que está menos ordenado. En realidad Boltzmann nunca usó las palabras orden y desorden en su artículo de 1877. Y, cuando aplicadas a las entropías relativas de una sistema, el orden y el desorden de los opuestos a veces confunden.

nos permite reiterar la segunda ley de la termodinámica en el lenguaje de multiplicidad. Debido a que un sistema aislado puede relajarse pero nunca puede imponer una restricción interna, la multiplicidad del macroestado final de un sistema aislado es al menos tan grande como la multiplicidad de su macroestado inicial. Algunos textos caracterizan la transición irreversible de un sistema internamente restringido a uno menos restringido como uno de un macroestado relativamente ordenado a uno que está menos ordenado. En realidad Boltzmann nunca usó las palabras orden y desorden en su artículo de 1877. Y, cuando aplicadas a las entropías relativas de una sistema, el orden y el desorden de los opuestos a veces confunden.

Alternativamente, podemos reemplazar el macroestado inicial ![]() con un macroestado de referencia especial

con un macroestado de referencia especial ![]() y la multiplicidad final

y la multiplicidad final ![]() con una multiplicidad macroestado arbitraria

con una multiplicidad macroestado arbitraria ![]() :

:

![]()

Al combinar cuidadosamente las ecuaciones anteriores, descubrimos exactamente que ideas están contenidas en estas expresiones para la entropía estadística y qué ideas no lo son. En particular: la entropía estadística de un sistema asilado es una función de la multiplicidad macroestado, es una función aditiva del estado y refleja la independencia de las partes aisladas.

Recuerde, sin embargo, una verdad termodinámica básica: todo lo conocido sobre el comportamiento termodinámico de un sistema, incluye cómo su entropía depende de sus extensas variables. Esto es así incluso cuando no se observan los supuestos especiales utilizados para determinar cómo la entropía estadística depende de la multiplicidad macroestado.

Por ejemplo, en las aplicaciones de un sistema de fluidos cerrados, de N-partículas, con variables extensivas: E-energía, V-volumen y número de N partículas. Sin embargo, dado que se conserva el número de partículas N en un sistema cerrado, sus macroestados son una función solo de E y V. En este caso, ![]() , y el resultado general se puede expresar como:

, y el resultado general se puede expresar como:

![]()

Por lo tanto, una vez que determinamos la función de multiplicidad ![]() y, al requerir aditividad, la “constante” c(N), conocemos la función de entropía. Y una vez que conocemos la función de entropía

y, al requerir aditividad, la “constante” c(N), conocemos la función de entropía. Y una vez que conocemos la función de entropía ![]() , a través de su derivadas, se conoce el sistema de ecuaciones de estado. Además, estas ecuaciones de estado se aplican en todas las situaciones, no solo cuando el sistema está cerrado y aislado. Describen, por ejemplo, cómo cambia el sistema cuando se calienta o se enfría, al realizar trabajo. En resumen, la presunción de un sistema asilado nos permite determinar la función de entropía y una vez que conocemos esta función ya no necesitamos mantener esta presunción.

, a través de su derivadas, se conoce el sistema de ecuaciones de estado. Además, estas ecuaciones de estado se aplican en todas las situaciones, no solo cuando el sistema está cerrado y aislado. Describen, por ejemplo, cómo cambia el sistema cuando se calienta o se enfría, al realizar trabajo. En resumen, la presunción de un sistema asilado nos permite determinar la función de entropía y una vez que conocemos esta función ya no necesitamos mantener esta presunción.

0.3 Cálculo de entropías

Un proceso estocástico se puede definir simplemente como una colección de variables aleatorias indexadas por tiempo. Los casos de tiempo continuo y discreto se pueden separar para definir procesos estocásticos con mayor precisión. Un proceso estocástico de tiempo discreto ![]() es una colección contable de variables aleatorias indexadas por números enteros no negativos, mientras que un proceso estocástico de tiempo continuo

es una colección contable de variables aleatorias indexadas por números enteros no negativos, mientras que un proceso estocástico de tiempo continuo ![]() es una colección incontable de variables aleatorias indexadas por números reales no negativos[8].

es una colección incontable de variables aleatorias indexadas por números reales no negativos[8].

Las aplicaciones del mundo real de la mayoría de los temas científicos, incluidos los procesos estocásticos, están plagadas de numerosas incertidumbres. Por tanto, muchos creen que los procesos estocásticos, que consisten en incertidumbres complicadas, no son predecibles[9]. Las aplicaciones de los conceptos de física y termodinámica para explicar fenómenos científicos se han estudiado con éxito en las últimas dos décadas. El concepto de entropía, que se deriva de la termodinámica, ha avanzado en nuestra comprensión del mundo[10]. La entropía es uno de los conceptos de la física que puede ser útil para rechazar la hipótesis nula de imprevisibilidad de los procesos estocásticos[11]. En este sentido, se han presentado varias métricas que incluyen la entropía de Shannon, la entropía de Renyi, la entropía de Tsallis, la entropía aproximada, la entropía de muestra, la entropía de transferencia y la entropía de permutación. El concepto de entropía es aplicable y útil para caracterizar el comportamiento de los procesos estocásticos, ya que representa la incertidumbre, la ambigüedad y el desorden del proceso sin causar ninguna restricción en la distribución de probabilidad teórica. Para cuantificar la entropía, se necesita una distribución de probabilidad asociada.

Los modelos heterocedásticos condicionales como los modelos de heterocedasticidad condicional autorregresiva generalizada (GARCH) se han estudiado tradicionalmente para medir las variabilidades en los procesos estocásticos debido a las incertidumbres inherentes. En este contexto, en primer lugar, presentamos el modelo tradicional, así como sus supuestos y limitaciones. A continuación, revisamos la literatura sobre la relación entre las medidas de entropía y la incertidumbre inherente a los procesos estocásticos. Esta área de estudio se caracteriza por numerosos estudios que reflejan diferentes medidas de entropía, incertidumbres, metodologías y aplicaciones. Discutimos trabajos académicos sobre el tema y sacamos conclusiones generales de estudios anteriores. Intentamos proporcionar un enfoque convincente del tema, identificar los hallazgos clave de la literatura y presentar las observaciones finales, así como las direcciones de investigación futuras.

0.3.1 Modelos heterocedásticos condicionales

Antes de que se introdujera la idea de utilizar medidas de entropía para el modelado y la cuantificación de la incertidumbre, tradicionalmente se estudiaban los clustering de volatilidad y memoria larga[12] para el modelado predictivo y la cuantificación de la incertidumbre basados ??en modelos heterocedásticos condicionales. Los modelos heterocedásticos condicionales son modelos estadísticos, que generalmente se utilizan para modelar series de tiempo. Estos modelos explican la varianza del término de error actual, conocido como innovación, en función de los términos de error de los períodos anteriores[13]. Ejemplos de modelos heterocedásticos condicionales son el modelo de heterocedasticidad condicional autorregresiva (ARCH), el modelo ARCH generalizado (GARCH), GARCH en -Modelo de media (GARCH-M) y modelo de GARCH exponencial (EGARCH). Los modelos heterocedásticos condicionales se utilizan principalmente para modelar el comportamiento estocástico de una serie de tiempo, que es un caso especial de proceso estocástico con datos de tiempo discretos. Los modelos heterocedásticos condicionales para las variaciones se basan en los promedios autorregresivos (AR) y móviles (MA).

La forma general del modelo de varianza GARCH, GARCH (p,q) se puede escribir de la siguiente manera:

14.45.57.png)

donde ![]() son parámetros del modelo con los siguientes supuestos:

son parámetros del modelo con los siguientes supuestos:

14.48.30.png)

Cabe señalar que los valores grandes de ![]() resultan en un gran valor de varianza en el momento t, que indican que Yt es menos predecible que el caso con valores más pequeños de

resultan en un gran valor de varianza en el momento t, que indican que Yt es menos predecible que el caso con valores más pequeños de ![]() . En otras palabras, valores grandes de

. En otras palabras, valores grandes de ![]() indican que Yt tiene más volatilidad.

indican que Yt tiene más volatilidad.

En el modelo GARCH-M[14], la varianza condicional ht, de la variable aleatoria![]() , dada la variable aleatoria Yt, es una función lineal de las variaciones condicionales de los períodos anteriores y el cuadrado de los errores de los períodos pasados:

, dada la variable aleatoria Yt, es una función lineal de las variaciones condicionales de los períodos anteriores y el cuadrado de los errores de los períodos pasados:

14.54.29.png)

Además, los términos de error, ![]() , se distribuyen según una distribución normal de la siguiente manera:

, se distribuyen según una distribución normal de la siguiente manera:

14.59.09.png)

donde Xt es el valor de riesgo, Yt es un vector predeterminado de variables, ![]() es un conjunto de información que explica la variabilidad en el proceso estocástico Xt y

es un conjunto de información que explica la variabilidad en el proceso estocástico Xt y ![]() indica que la información actual es significativa con respecto a pronosticar la variable aleatoria futura Xt . Cabe señalar que si la información llega en conglomerados, la variable aleatoria Xt también puede presentar agrupamiento.

indica que la información actual es significativa con respecto a pronosticar la variable aleatoria futura Xt . Cabe señalar que si la información llega en conglomerados, la variable aleatoria Xt también puede presentar agrupamiento.

En el modelo EGARCH[15], el logaritmo de la varianza condicional sigue un AR como se muestra a continuación:

15.04.26.png)

donde ![]() son parámetros. Se observa que

son parámetros. Se observa que ![]() no son necesariamente no negativos. Como se muestra en las ecuaciones (6) - (10), las varianzas dependen tanto del signo como del tamaño de los residuos rezagados.

no son necesariamente no negativos. Como se muestra en las ecuaciones (6) - (10), las varianzas dependen tanto del signo como del tamaño de los residuos rezagados.

En resumen, los modelos de la familia GARCH se pueden utilizar para modelar los procesos estocásticos con incertidumbres endógenas y exógenas complicadas, como las series de tiempo. Para construir el modelo GARCH apropiado que se ajuste al conjunto de datos, los parámetros GARCH deben estimarse con base en los datos históricos. Se observa que los parámetros de orden del modelo p y q se pueden especificar de acuerdo con las autocorrelaciones de los residuos estandarizados. El exponente de Hurst es otra métrica que se puede utilizar para medir la memoria a largo plazo de series de tiempo. El exponente de Hurst se puede estimar ajustando la ley de potencia al conjunto de datos en forma de serie temporal. Representa las autocorrelaciones[16] de la serie temporal y cómo las autocorrelaciones disminuyen a medida que aumenta el número de rezagos. La autocorrelación entre las observaciones desafía la imprevisibilidad de los procesos estocásticos, ya que los datos futuros se pueden pronosticar con base a los datos anteriores. Sin embargo, el parámetro de Hurst, de forma aislada, no es suficiente para concluir la presencia de memoria a largo plazo. La direccionalidad entre los diferentes puntos de datos no se refleja en la correlación cruzada[17]. Otro enfoque para estudiar los fenómenos de acumulación de memoria larga y volatilidad es mediante el uso de medidas basadas en el concepto de entropía, incluida la entropía de Shannon, entropía Renyi , entropía de Tsallis, entropía de transferencia y entropía de muestra.

0.3.2 Medidas de entropía para la cuantificación de la incertidumbre

0.3.2.1 Entropía de Shannon

La entropía fue discutida por primera vez por Clausius en 1865 para explorar la inclinación de la intensidad del calor, la presión y la densidad a desaparecer gradualmente con el tiempo. Con base en este concepto, Clausius estableció la Segunda Ley de la Termodinámica, afirmando que es probable que la entropía de un sistema aislado aumente hasta que alcance su estado de equilibrio. Schwill[18] y Shannon[19] ampliaron el concepto de entropía y afirmaron que la entropía no se limita a la termodinámica y puede aplicarse en cualquier sujeto con naturaleza probabilística[20]. El concepto físico de entropía es en realidad un caso especial de la entropía de Shannon, ya que cuantifica probabilidades en el espacio de estado completo.

Schwill afirmó que la entropía es una medida de incertidumbre en variables aleatorias. Para una variable aleatoria X sobre un espacio de probabilidad ![]() y distribución de probabilidad

y distribución de probabilidad ![]() , la entropía de Shannon se define de la siguiente manera:

, la entropía de Shannon se define de la siguiente manera:

15.20.58.png)

donde ![]() y

y ![]() son medidas de entropía para variables aleatorias continuas y discretas, respectivamente. Además, las ecuaciones (11) y (12) se pueden explicar de la siguiente manera:

son medidas de entropía para variables aleatorias continuas y discretas, respectivamente. Además, las ecuaciones (11) y (12) se pueden explicar de la siguiente manera:

15.22.38.png)

Como se muestra en la ecuación (13), el valor esperado de ![]() es equivalente a la entropía de Shannon. Cabe señalar que las unidades de medida originales para la entropía son bits, que son unidades de información necesarias para almacenar un símbolo en un mensaje. La entropía también se puede utilizar como una forma de medir la incertidumbre de los procesos aleatorios. El estado con

es equivalente a la entropía de Shannon. Cabe señalar que las unidades de medida originales para la entropía son bits, que son unidades de información necesarias para almacenar un símbolo en un mensaje. La entropía también se puede utilizar como una forma de medir la incertidumbre de los procesos aleatorios. El estado con ![]() puede ser justificado por:

puede ser justificado por: ![]() . También se observa que, como mostraron Kullback y Leibler[21], la definición de entropía de Shannon carece de una medida invariante y en el caso absolutamente continuo depende de las parametrizaciones. El concepto de entropía de Shannon se ha aplicado a diferentes dominios, incluidos los sistemas de potencia, física, finanzas, biología, fisiología, y series cronológicas cardiovasculares[22].

. También se observa que, como mostraron Kullback y Leibler[21], la definición de entropía de Shannon carece de una medida invariante y en el caso absolutamente continuo depende de las parametrizaciones. El concepto de entropía de Shannon se ha aplicado a diferentes dominios, incluidos los sistemas de potencia, física, finanzas, biología, fisiología, y series cronológicas cardiovasculares[22].

La predictibilidad de la serie temporal utilizando una nueva medida de dependencia[23], que funciona de manera similar a la entropía de Shannon de la siguiente manera:

15.30.34.png)

donde ![]() es la densidad conjunta y

es la densidad conjunta y ![]() y

y ![]() son las densidades marginales de las variables aleatorias X y Y.

son las densidades marginales de las variables aleatorias X y Y.

Las propiedades interesantes de esta medida de dependencia son las siguientes:

1) Es aplicable tanto en casos discretos como continuos.

2) Se encuentra dentro del rango de 0 a la unidad. Se normaliza a 0 en el caso de la independencia y el módulo de la medida es 1 en el caso de la relación exacta medible entre las variables aleatorias.

3) En el caso de una distribución normal bivariada, esta medida de dependencia tiene una relación simple con el coeficiente de correlación.

4) Mide no solo la distancia sino también la divergencia.

Además, comparan sus resultados numéricos con los de un conjunto de medidas tradicionales. Muestran que su medida de entropía es capaz de descubrir una dependencia no lineal en la serie de tiempo[24]. Hasta donde sabemos, el trabajo de Maasoumi y Racine ya citado, es uno de los primeros estudios relacionados con las medidas de entropía, la incertidumbre y la predictibilidad de las series de tiempo.

0.3.2.2 Entropías de Renyi y Tsallis

La entropía de Shannon funciona bien solo si la capacidad de almacenamiento de un canal de transmisión es finita. Renyi presenta una nueva medida de entropía conocida como entropía de Renyi de orden ![]() para variables discretas[25], que se define de la siguiente manera:

para variables discretas[25], que se define de la siguiente manera:

15.40.18.png)

donde ![]() y

y ![]() . Se observa que en el caso de límite

. Se observa que en el caso de límite ![]() , la entropía de Renyi y la entropía de Shannon son idénticas.

, la entropía de Renyi y la entropía de Shannon son idénticas.

Entropía de Tsallis para cualquier número real no negativo ![]() , se puede estimar como se muestra en la siguiente fórmula: